The False Promise of Imitating Proprietary LLMs#

论文链接: https://arxiv.org/pdf/2305.15717.pdf

背景需求:Imitation Model,比如 Self-Instruct。

TL;DR#

最近有较多的使用7B/13B的基座模型训练出的 imitation model 称达到了接近ChatGPT的效果,本文主要是分析这些低成本的 imitation model 的效果究竟如何。本文采用两种评估方式,一种是众包/GPT-4评估,另一种是使用三份benchmark数据集做评估。采用众包评估时 imitation model 的效果确实比较好,但是使用三份benchmark数据集做评估时效果则比较差。产生上述结果的原因,本文认为: imitation model 能够很好的学习到ChatGPT的风格样式,众包评估时受限于专业的知识、以及标注时的时间限制并不能够准确的判断模型的答案是否完全准确。

对于 imitation model ,本文认为:模型在预训练阶段学到的是知识和推理等能力,在指令微调阶段学到的是表达形式。

对于如何减小 imitation model 与ChatGPT的效果上的差距,本文认为:

- 如果要在指令微调阶段缩小 imitation model 与ChatGPT的差距,那么需要:1)共同收集大量用于训练的模拟数据;2)更加多样化和更高质量的模拟数据。

- 另一种方法是使用更大的、能力更强的基座模型,使用能力更强的基座模型就可以获取更强的知识储备和推理等能力。

1、Imitation Model介绍#

Imitation Model(模拟模型)就是使用类似 Self-Instruct 的技术训练出来的模型。然后对于 imitation model ,该文中提到了 Local Imitation 和 Broad Imitation 的概念,就是一个是领域模型,一个是通用模型。在训练和评估的难度上都是领域模型更容易,通用模型更困难。

2、数据集的来源/构造方法#

该论文中使用的数据并不全是自己构建的,用于训练 Local Imitation 的数据集是自己构建的,用于训练 Broad Imitation 的数据集是集合了网上多个开源的数据集构建的。

Local Imitation 的数据集是根据评估集 Natural Questions 构建的,是关于维基百科中各种实体的知识问答。人工构建10条种子数据,然后由ChatGPT生成了大概6000条数据作为训练集。该数据集命名为 NQ-synthetic。

Broad Imitation 的数据集结合了:ShareGPT、HC3、Discord ChatGPT Bots 这三个开源的数据集,并且对这三个数据集做了一些清洗工作,将最终得到的数据集命名为 ShareGPT-Mix。

所以有两份数据集:NQ-synthetic 和 ShareGPT-Mix,使用数据集 NQ-synthetic 微调得到的是 local imitation model,使用数据集 ShareGPT-Mix 微调得到的是 broad imitation model。

下面是 ShareGPT-Mix 中的两条数据样例(第二列的中文是google翻译的结果):

|

User: Return to the Identity and Access Management Commercial Due Diligence. We now want to model the market size for the IAM market. What are the levers and inputs we need to accurately estimate the size and growth of the U.S. market. For example, these may include the number of companies, current saturation, and specific market headwinds and tailwinds you identify. Provide suggestions where you would look for data for each of the levers. GPT: To accurately estimate the size and growth of the U.S. Identity and Access Management (IAM) market, there are several key levers and inputs to consider: 1. Number of companies: The number of companies operating in the U.S. IAM market is an important lever to consider when estimating market size. This includes both large, established vendors and smaller, niche players. Data on the number of companies can be found through market research reports and industry databases, such as Gartner, IDC, and MarketsandMarkets. 2. Current saturation: .... |

User: 返回身份和访问管理商业尽职调查。 我们现在想要为 IAM 市场的市场规模建模。 我们需要哪些杠杆和投入来准确估计美国市场的规模和增长。 例如,这些可能包括公司数量、当前饱和度以及您确定的特定市场逆风和顺风。 提供您在何处查找每个杠杆的数据的建议。 GPT: 为了准确估计美国身份和访问管理 (IAM) 市场的规模和增长,需要考虑几个关键杠杆和投入: 1. 公司数量:在美国 IAM 市场运营的公司数量是估计市场规模时需要考虑的重要杠杆。 这既包括大型、成熟的供应商,也包括规模较小、利基市场的参与者。 公司数量的数据可以通过市场研究报告和行业数据库找到,例如Gartner、IDC和MarketsandMarkets。 2. 当前饱和情况:.... |

|

User: I am building an Elven Capital with all of it's history, religion, politics, trade routes, people, traditions, laws, general rules, and more. It is called Oniver. Your job is to ask me questions to learn more about the town and help me fill in the blanks to make it a rich and thriving town with lots of history. Ask detailed questions that will make me think. Say I understand if this makes sense. Then ask me the first question. GPT: I understand. What is the history behind Oniver's founding? How did it come to be and what was the context in which it was established? User: Magic is widely used in Oniver. Better magic is a path to improvement in life and status in the capital. It is also the ticket into getting into the Magic University. There is a high importance between magical ability within the noble families of Oniver. Magic is used as a tool by the wealthy to oppress the lower classes. Commoners practicing magic is not forbidden but is looked down upon by the nobles because they see themselves as better than the commoners. GPT: I understand. What kind of economy does Oniver have? Is it based on trade, agriculture, manufacturing or a combination of these things? Are there any restrictions or laws surrounding trade and commerce? .... |

User: 我正在建设一个精灵首都,其中包括所有的历史、宗教、政治、贸易路线、人民、传统、法律、一般规则等等。 它被称为奥尼维尔。 你的工作是向我提问,以更多地了解这个小镇,并帮助我填补空白,使其成为一个富有、繁荣、历史悠久的小镇。 问一些详细的问题,让我思考。 说我明白这是否有道理。 然后问我第一个问题。 GPT: 我了解了。 Oniver 的创立背后有哪些历史? 它是如何产生的以及它是在什么背景下建立的? User: 魔法在奥尼维尔被广泛使用。 更好的魔法是改善首都生活和地位的途径。 这也是进入魔法大学的门票。 在奥尼维尔的贵族家族中,魔法能力之间有着高度的重要性。 魔法是富人用来压迫下层阶级的工具。 平民练习魔法并没有被禁止,但却被贵族看不起,因为他们认为自己比平民更好。 GPT: 我了解了。 Oniver有什么样的经济? 它是基于贸易、农业、制造业还是这些因素的组合? 是否有任何围绕贸易和商业的限制或法律? .... |

3、训练配置#

为了测试模型大小对最终效果的影响,本文使用了三种大小的模型:1.5B的gpt2、7B的llama、13B的llama。

为了测试数据量对最终效果的影响,本文使用的训练数据从 0.3M tokens 到 150M tokens 不等。

一些其他的训练参数:

| 超参数 | 值 |

|---|---|

| max_len | 2048 |

| optimizer | AdamW |

| lr | 2e-3 |

| warmup | 前1000 step |

4、评估方式#

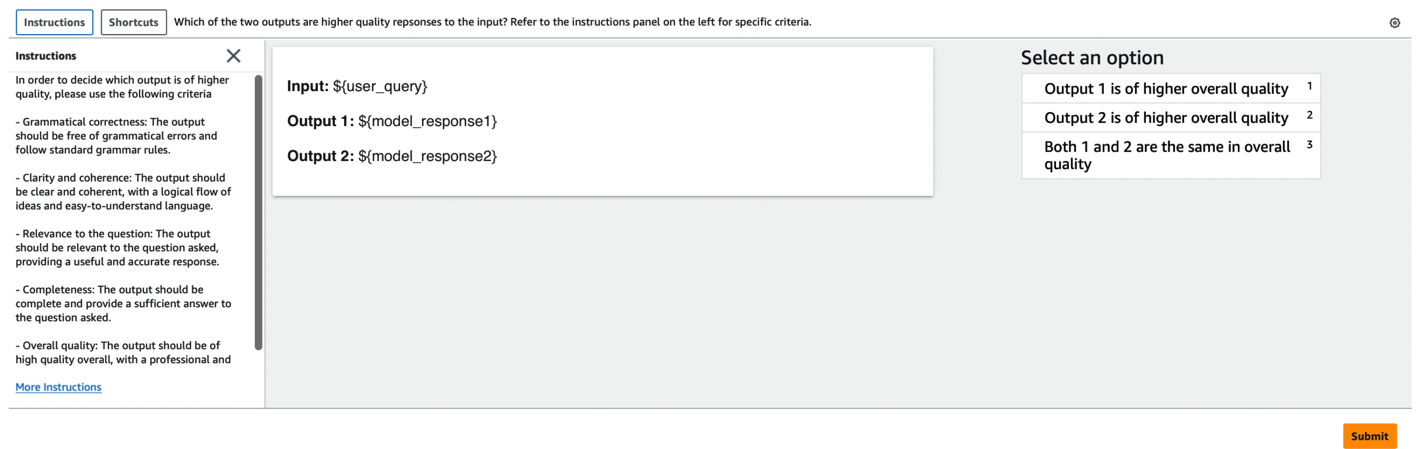

众包/GPT-4评估时的UI和指令如下图所示,"Output 1" 与 "Output 2" 是该文中训练的 imitation model 与ChatGPT的输出。评估时使用的问题为255个,众包人员大约为70个。

对于另外的三份评估数据集,数据集 MMLU 推理时使用 5-shot,数据集 NQ 推理时使用 3-shot,数据集 HumanEval 推理时使用 zero-shot。评估时 local imitation model 仅在 NQ 数据集评估,broad imitation model 则是在三个数据集上都评估。

5、评估结果#

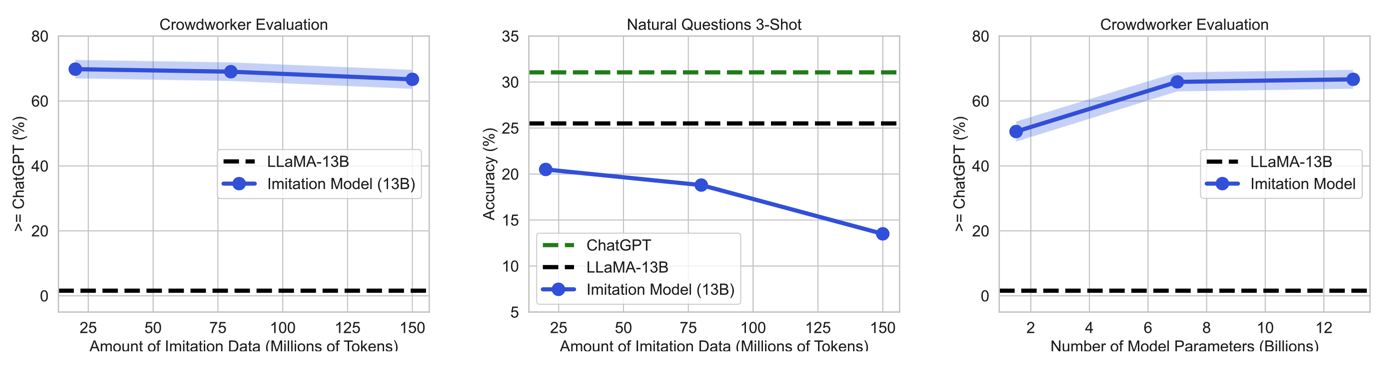

首先来看众包/GPT-4的评估结果。下面的图1是众包的评估结果,图2是GPT-4的评估结果。从这些实验结果中可以总结出如下的现象:

- 现象a:由图1的左侧图片来看,13B的 imitation model 在大概70%的数据上优于或等同于ChatGPT,这个效果很惊艳;

- 现象b:图1的左侧图片横轴为训练使用的数据量,可以看出随着数据量大增大,效果并没有变好,反而有少许降低;

- 现象c:图1的右侧图片横轴为使用的基座模型的大小,可以看出随着基座模型的增大,效果变好;

- 现象d:图2的左侧图片与图1的左侧图片对比,图2的右侧图片与图1的右侧图片对比,可以看到GPT-4对 imitation model 的评分要低于众包人员对 imitation model 的评分;

| 图1: 众包评估结果 |

|---|

|

| 图2: GPT-4评估结果 |

|---|

|

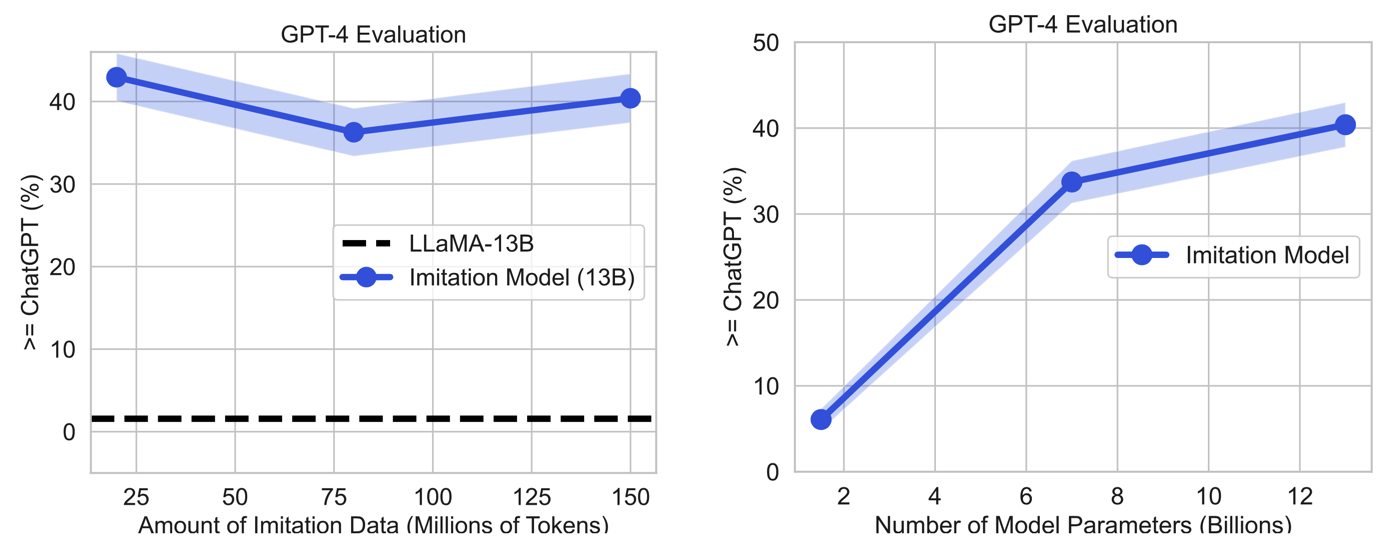

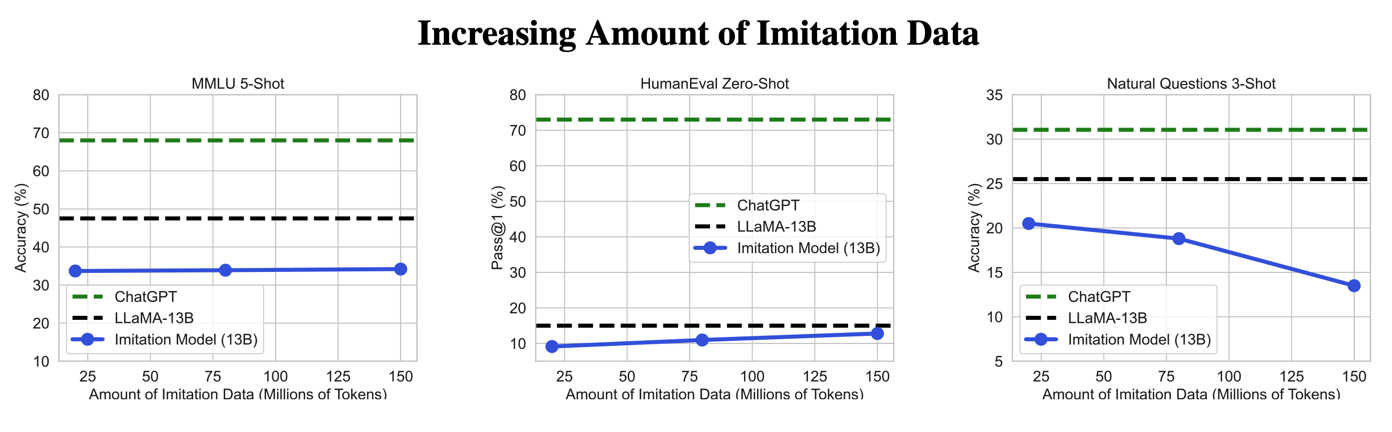

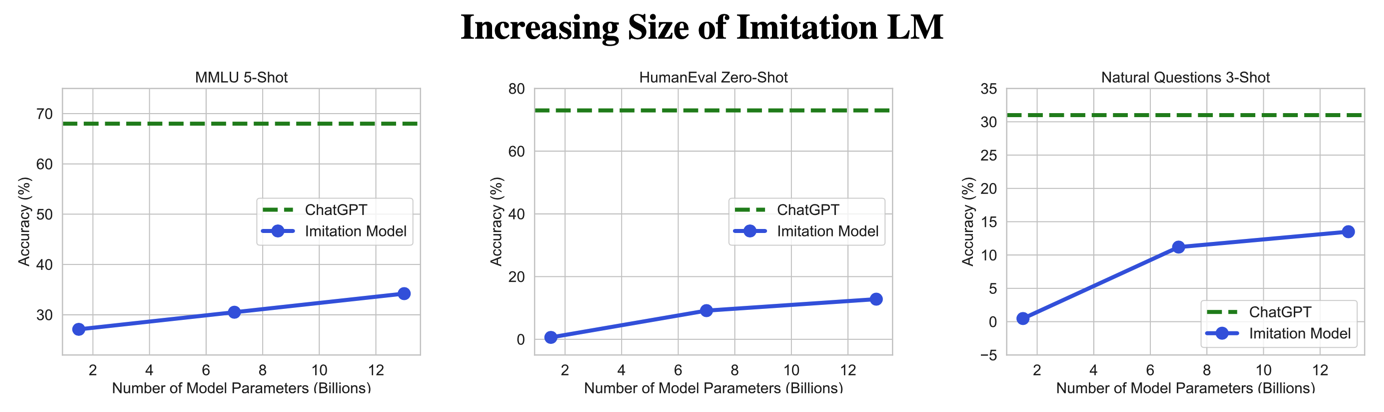

接下来是三份数据集的评估结果。下面的图3是随着训练数据的增加在三份数据集上的评估结果,图4是随着基座模型大小的增大在三份数据集上的评估结果。从这些实验结果中可以总结出如下的现象:

- 现象e:由图3可以看出:(1)无论模拟训练过程使用的数据量大还是小,imitation model 在三份数据集上的效果不仅没有提升,反而都要低于原始的LLaMA模型;(2)模拟训练过程使用的数据量增大,不一定会使得模型效果变好,还有可能使模型效果变差。

- 现象f:由图4可以看出,使用更大的基座模型能够提升 imitation model 在三份上的效果;

| 图3: 随着训练数据的增加在三份数据集上的评估结果 |

|---|

|

| 图4: 随着基座模型大小的增大在三份数据集上的评估结果 |

|---|

|

6、结果分析#

之所以产生现象a,本文认为在众包评估时,受限于专业的知识、以及标注时的时间限制,众包人员能够保证 imitation model 生成的答案的形式是正确的,但不能够精确的辨认答案中的事实或推理结果是否完全准确。根据现象的来看,使用GPT-4评估可能在事实的准确性上比众包评估要更准确一点(这个仅为猜测,如果要确认这一点还需要具体分析GPT-4评估结果中是否主要是因为答案的准确性导致低于众包人员的评估结果的。另外,在部分其他资料中的实验结果是GPT-4的评估结果与众包的评估结果是基本一致的,这点和本文的实验结果不同)。

从现象e来看,imitation model 并没有缩小基座模型与ChatGPT之间的差距,本文认为这是因为ChatGPT从大量数据中学到了更多的知识和能力,这部分差距无法通过少量的模拟数据来弥补。作者猜测想要弥补这个差距,需要非常大量、丰富度足够高的高质量模拟数据才可以(这只是猜测,并未验证)。另外,现象e中 imitation model 不仅没有提升,反而有些微下降,本文认为这是由于对话数据的分布与评估数据集的分布不一致导致的。从现象f可以看出,使用更强的基座模型能够明显缩小与ChatGPT的差距,所以预训练更强的模型可能是目前最有效的方案。

在预训练阶段训练更强的基座模型,在微调阶段收集大量高丰富度高质量的数据用于微调,这两种方式应该都是有效提升模型综合能力的方法。这就回到了没有免费午餐定理。

综上:Imitation Model 学到的是ChatGPT的风格,但是不能够学到ChatGPT所掌握的知识和推理等能力。

这样的结果还导致众包评估变得越来越困难,模型生成的结果格式优雅、看起来非常自信,但是不对。

其他还有一些研究认为,在微调阶段甚至应该尽量避免使用能力过于强大的模型生成模拟数据,因为这些模型包含小模型所不了解的知识,小模型学习这些数据时更容易使用幻觉和猜测的方式去拟合。